你通过一款语言应用程序,发送了一段简短的语音。一周后,一则线上广告弹出。广告中的声音听起来和你无比相似。不仅语调相似,就连语句的抑扬顿挫也一样。但你其实却从未同意让自己的声音出现在广告里。

以上并不是科幻故事的情节,而是已经发生的事实。从语音信息和自拍,到与聊天机器人的随意对话,其实人工智能应用都正在不断向我们学习。某些情况下,它们会使用这些数据生成新的内容,所呈现的脸孔或声音,看起来、听起来都和你非常相像。

在马来西亚快速接纳数码科技便利的过程中,我们可能付出了超出自己意识到的代价。或许现在是时候问一句:“我们是否在对人工智能过度分享?”

人工智能如何向你学习——且往往未曾征求你的同意

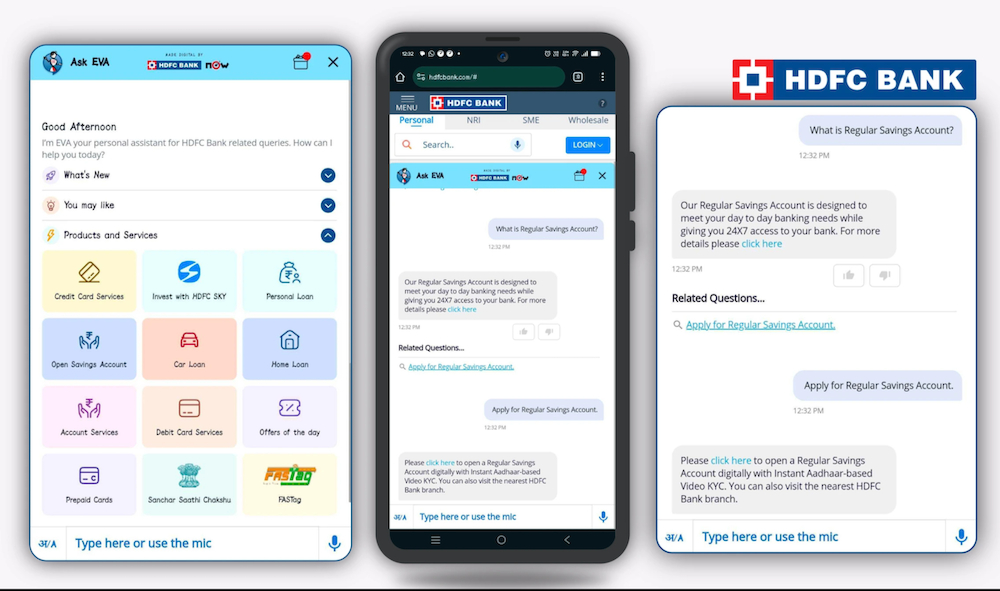

人工智能无处不在。无论你是在与银行的虚拟助理聊天机器人对话、浏览Shopee的推荐商品,或是玩转TikTok的滤镜,其实某种形态的人工智能都正在程序的后台运行,同时观察、学习并适应你。

“很多人没有意识到人工智能其实并不是什么新事物,”马来西亚理科大学网络安全研究中心主任Selvakumar Manickam教授说。“它多年来一直是自动化、诊断和金融系统的一部分。如今不同的是生成式人工智能技术的兴起——这些工具会根据训练数据生成新的内容,而这些数据往往就包括了你提供的数据在内。”

他解释,像ChatGPT这样的系统并非真正人类意义上的“聪明”。“它们并不理解;它们是在预测,”他说。“这些模型是用来自整个互联网的大量数据训练出来的,其中有些资讯是事实,有些不是。人们以为得到的回应肯定是正确的,但其实往往只是听起来合理的模式组合。”

在马来西亚,互联网普及率高、数码化习惯根深蒂固,人工智能已经很自然地融入日常生活。但很少有人停下来思考:“我刚才提供给这个应用程序的数据会发生什么事?”

我们是否正在对人工智能应用程序过度分享?

如今许多人工智能工具被设计得感觉上像是客制化的、友善的、甚至是关怀人心的。这正是问题所在。

我们像与朋友一样与机器人聊天、上传自拍试用滤镜、毫无疑心地录制语音。我们通常从未仔细阅读条款与条件。

“马来西亚人,尤其是年轻用户,是原生网络使用者,”Selvakumar说。“他们的线上和线下生活深度交织。分享个人想法、自拍或语音感觉上再自然不过。这是社会认同、潮流文化和便利的一部分。”

他提到一份2024年的报告指出,马来西亚人平均每天上网超过八小时,位居全球前列。“有句话说,‘一旦上传到网络,它就永远存在。’尤其是当你的数据被用来训练人工智能模型时,这点更是真实。”

这种使用起来的轻松感正是许多人工智能应用所依赖的——它们以即时、可见的奖励,交换不甚明显的东西:你的个人资料。

当你的数据变成别人的内容

如今的人工智能工具可以复制声音、模仿脸孔,甚至以你的语气生成讯息;它们只需要只少量样本即可办到。

在马来西亚,诈骗者已开始使用人工智能生成真实人物声音和脸孔的深伪影像(deepfake)。雪兰莪曾发生一起案例,一名女子在接到一个听起来与上司极为相似的电话后,损失了RM5,000。声音是利用人工智能生成的——可能来自公开资料或录音的复刻版。

当局也警告现已出现以国家领袖面孔,包括以首相安华与最高元首在内制作而成的深伪视频,用于推销虚假的投资计划。

这些案例凸显了脸部与声音数据被滥用的风险,以及当个人数据被轻易取得时,人工智能会迅速模糊了真实与伪造的界线。

“人们以为点击‘接受’只是同意了基本功能,”Selvakumar说。“但这些协议往往隐藏模糊条款,如‘用于服务改进’。那可能意味着任何事,包括训练未来的人工智能系统。”

他补充:“现实中根本不存在真正免费的应用。如果你不需要付费,你可能就是用你的个人数据做交换。”

伦理盲点:谁在划界?

马来西亚《个人资料保护法》(PDPA)提供了一些基本保障,但事实上仍不足够。条例并不涵盖面部识别、声音复制或跨境数据训练。而许多热门应用甚至没在本地设立总部。

Selvakumar直言:“目前的做法——将‘同意’隐藏在冗长、难以阅读的条款里是不道德的做法。真正的同意必须是清楚、具体且可被自由选择的。”

他呼吁推动超越合规层面的人工智能实践:

明确地选择加入逐项数据

可解释人工智能(XAI),让用户理解决策过程

数据最小化原则,意即应用程序只收集必要的数据

被遗忘权,让用户能够删除自己的数据

第三方审核,以验证隐私与安全标准

“唯有透明、问责与真正的选择,才能建立公众对人工智能的信任,”他说。

逝去艺人、人工智能复制与文化不安

还有一个更令人不安的问题:使用人工智能“复活”已故艺术家的声音。

以Elvis Presley、Michael Jackson,甚至已故的P. Ramlee等歌手的声音制作的人工智能歌曲,已在网上流传。有些人视之为致敬;有些人认为这是一种不尊重。

“使用人工智能创作已故艺术家声音的歌曲,是一个复杂而具争议的趋势,”Selvakumar 说。“虽然技术令人赞叹,但伦理道德层面上其实说不清。这些艺术家已经不能给予许可,而他们的声音可能被用于他们绝不会同意的方式——政治、商业或艺术。”

他提到印度曾出现一宗案例,即使相关家庭已被征求过意见,但一段使用已故歌手声音的人工智能原声带仍旧引发了公众争论。

Selvakumar支持强制标注人工智能生成内容,而中国已开始实施。“如果一个声音或脸孔是人工智能生成的,人们有权知道,”他说。

马来西亚人现在能做些什么?

在法规逐步跟上之前,用户仍可通过日常简单措施保护自己:

分享前先暂停一下:人工智能不是你的治疗师或朋友

避免在非必要情况下让应用程序存取相机、麦克风或联系人

使用具明确隐私政策与退出选项的可信平台

不向聊天机器人或滤镜共享敏感资料(身份证号、银行资料)

教育身边的人,尤其是青少年与长辈,了解人工智能滥用、诈骗与深伪风险

“媒体素养是我们最好的防线,”Selvakumar说。“科技会不断进化,但若用户变得更具批判精神、更了解现况,他们就能推动更好的标准。”

人工智能不是敌人,盲目信任才是

人工智能并不是要伤害我们。它只是按设计,从我们提供的东西中学习。但当这种学习在后台进行、且未得到我们充分理解或同意时,风险便随之增加。

随着马来西亚迈向更具深度的数码未来,我们也必须同样快速地建立认知。人工智能极其有用,但前提是必须建立在信任、透明与尊重个人权利的基础上。

你的声音、你的脸孔、你的习惯——这些不只是数据点。它们比你想象的更有价值,因此不要盲目地交出来。在将它们分享给应用或聊天机器人之前,问问自己:我真的知道这些数据会去向何处吗?

不是每个应用程序都值得拥有这种权限,更不值得为了一时的便利而承担这些风险。

该《S.A.F.E Internet》的系列是与CelcomDigi合作推出。

本文内容是作者个人观点,不代表《当今大马》立场。